1. Introducción

La entonación es un componente esencial de la lengua, pues no solamente es un indicador de la información lingüística, sino también de la sociolingüística, especialmente durante la realización particular de una lengua en cada región o grupo social. Asimismo, el tono define aspectos relacionados con la paralingüística, como los sentimientos, los estados de ánimo y las actitudes de los hablantes. Este tipo de significados paralingüísticos se han descrito en diferentes lenguas y en el español de otras regiones, pero no en México. A pesar de ser un componente esencial para cualquier intercambio lingüístico, se trata de un fenómeno difícil de describir, pues combina en sí mismo componentes gramaticales, pragmáticos y no verbales. Además, puede presentar múltiples realizaciones dependiendo de cada contexto y cultura. Por esta razón, es relevante encontrar los aspectos que coinciden entre las características prosódicas y las emociones, sobrepasando estas dificultades.

Este trabajo contribuye al esbozo de una descripción de la prosodia emocional del español en general y en particular del mexicano. Para ello, se lleva a cabo el diseño de un corpus actuado que permite dar cuenta del comportamiento de la curva entonativa de las emociones en una serie de enunciados aseverativos caracterizados por la misma estructura acentual y número de sílabas. Además, se relacionan los datos encontrados con la teoría bioinformacional de las emociones (Lang, Bradley & Cutbert, 1997) que permite conceptualizarlas dentro de un modelo continuo con rasgos de activación y valencia para lograr una mejor caracterización de sus manifestaciones prosódicas, independientemente de las realizaciones particulares de cada hablante.

En el primer apartado de este artículo se presentan los modelos teóricos y analíticos utilizados para la descripción de la prosodia emocional, cuyos elementos se integran en la parte metodológica. A continuación, se expone un breve panorama acerca de los estudios en torno a la prosodia de las emociones del español. Después, se comparten los resultados de este análisis que permiten una caracterización preliminar del perfil melódico de las emociones del español mexicano a partir de los rasgos de activación y valencia. Finalmente, se presentan las conclusiones, en las que se resumen los hallazgos del trabajo, sus alcances y sus limitaciones.

2. Modelos teóricos para el análisis de la prosodia emocional

El análisis de la prosodia ha seguido diferentes modelos a lo largo de la historia, pero pueden resumirse en dos vertientes: la primera, centrada en la descripción de la configuración fonética de las frases entonativas y, la segunda, en un análisis fonológico por niveles que describe ciertos puntos de contraste. Utilizando distintas terminologías, todos los modelos tratan de dar cuenta del contorno melódico que refleja movimientos de ascenso y descenso, pero se centran en distintas unidades de análisis, tomando como referencia a la configuración nuclear o bien prestando atención a toda la melodía y los cambios que ocurren en diferentes puntos del enunciado.

El modelo de análisis por niveles ha tenido diversas interpretaciones, pero en general busca la representación de los contornos a través de un sistema de unidades discretas: acentos, niveles y junturas, que forman a su vez morfemas tonales. En este contexto, se desarrolló la perspectiva de la fonología autosegmental (Goldsmith, 1976), que representa los elementos fonológicos no de forma concatenada o lineal como se había hecho anteriormente, sino registrando en secuencias paralelas el plano melódico -los segmentos y rasgos- y el prosódico (estructura). Junto con esta, se desarrolló la teoría métrica (Liberman & Prince, 1977), la cual se enfoca principalmente en la importancia del acento por su relación de prominencia entre núcleos silábicos pertenecientes a unidades mayores y dependientes sintácticamente de la frase entonativa.

A partir de estas perspectivas, surge el modelo de análisis métrico-autosegmental (Ladd, 2008; Pierrehumbert, 1980), el cual busca describir los diferentes contornos melódicos de las lenguas a través de un sistema entonativo que combina diferentes elementos fonológicos contrastivos prosódicamente marcados. En los años noventa este modelo es sistematizado mediante la transcripción prosódica Sp_ToBI -Tones and Break Indices-, utilizado en diferentes lenguas y aplicado al español en el Sp_ToBI por (Beckman, Díaz-Campos, Tevis & Morgan, 2002) con todas las convenciones necesarias para lograr la notación fonémica de la entonación. Este modelo ha tenido varias revisiones, entre las que se destacan las realizadas por Hualde (2003), Estebas y Prieto (2008), Hualde y Prieto (2015).

En el sistema Sp_ToBI se describen cuatro niveles: el ortográfico, el tonal, el fraseo melódico y el misceláneo para fenómenos paralingüísticos. Para la descripción parte de dos unidades fonológicas: los acentos tonales anclados en sílabas tónicas representadas con el diacrítico (*) y los tonos de juntura o límites prosódicos marcados con (-) o (%), dependiendo si son intermedios o finales, respectivamente. Los tonos se representan mediante dos etiquetas L (Low) para los tonos bajos y H (High) para los altos, dependiendo de los valores tonales adyacentes y del tono global del hablante. De acuerdo con el umbral de percepción descrito anteriormente (Pamies, Fernaández Planas, Martínez, Ortega & Amorós, 2002), corroborado por Murrieta (2016) y utilizado en otros trabajos como el de Fernández Planas y Martínez Celdrán (2003), las diferencias de al menos 1.5 st se etiquetan como acentos bitonales, mientras que los mayores a 3 st se marcan con el diacrítico (¡) para ascensos y (!) para descensos. Los picos desplazados se marcan con (>) (Estebas-Vilaplana y Prieto, 2008). Combinando estos elementos, se puede definir la curva entonativa e identificar las configuraciones nucleares, partiendo de los valores de la frecuencia fundamental (F0) (Pierrehumbert, 1980).

En este punto, es importante retomar las diferencias conceptuales entre entonación prelingüística, lingüística y paralingüística (Cantero, 2014), que permiten entender la complejidad del fenómeno entonativo, pero a su vez, como menciona Ballesteros (2014) es un «proceso de abstracción útil para el estudio fonético de la melodía», pero que conlleva a un elevadísimo coste teórico en el que se pierde su interdependencia estructural; esta división, aunque permite hacer una clasificación teórica, se debe recordar que «los tres niveles se implican mutuamente» en un fenómeno unitario (pp. 51-52).

Por un lado, la entonación prelingüística comprende los fenómenos de acento, ritmo y melodía, cuya función es delimitar e integrar las unidades discursivas por el contenido lingüístico que contienen en un perfil melódico. En este nivel se incluye la melodía de la pronunciación asociada a una lengua específica o a un acento dialectal.

Por otro lado, la entonación lingüística incluye los rasgos melódicos, que permiten distinguir los tonemas o unidades funcionales de la entonación que son fonológicamente significativos y pueden asociarse a una forma fónica definida. Estos tonemas brindan una base, pero pueden variar dependiendo de la entonación paralingüística o estilística que se le añada, dando lugar a diferentes tipos de exclamaciones, interrogaciones o aseveraciones. Las variantes melódicas paralingüísticas expresan factores pragmáticos como la personalidad, el grado de seguridad y las emociones, que son el centro de esta investigación.

La expresión de las emociones en la voz puede ser muy variable, dependiendo de la función a la que acompañe y las motivaciones intrínsecas del hablante. Es por ello que para el estudio de la prosodia emocional puede partirse de enunciados aseverativos, caracterizados por una entonación no marcada o neutra, para dejar la expresividad al componente emocional, el cual se espera que modifique la construcción prosódica (Martín Butragueño, 2015). Al respecto, cabe recordar que este puede presentarse en cualquier tipo de acto de habla: directivos, declarativos, expresivos, interrogativos, etc.

De forma ideal, el análisis prosódico debe estar basado en el habla en uso, que promueve una mayor espontaneidad (Martín Butragueño, 2015), pero en ocasiones se utilizan emisiones más controladas para mejorar la calidad del audio, la facilitación del análisis y la sistematización de los datos a partir de patrones comparables entre sí (Face, 2010).

2.1. El modelo bioinformacional y la teoría del código biológico

Las emociones son una característica inherente a los seres humanos que acompaña la mayoría de las acciones diarias y determina la interacción con los otros. Durante la comunicación verbal se transmite de forma implícita gran parte del contenido emocional que acompaña al mensaje explícito, lo complementa, modifica o, en ocasiones, cambia totalmente su significado. La naturaleza de las emociones ha generado interés desde muchas perspectivas y campos de estudio. Ya Darwin (1872) habla de la voz como una reacción física portadora de señales afectivas relacionadas con la lucha por la supervivencia y cómo estos patrones, al igual que otros comportamientos humanos, han evolucionado para resolver ciertos problemas de la especie.

En la literatura pueden encontrarse múltiples definiciones de las emociones como estados de la mente, al detectar reacciones físicas que ocasionan a su vez variaciones acústicas en la voz (Banse & Scherer, 1996). En ese sentido, James (1884) define las emociones como la forma en que se perciben los cambios físicos ante un hecho excitante. Estos cambios involucran cambios coordinados en varios componentes como: activación neuropsicológica, expresión motriz, sentimientos subjetivos y, posiblemente, tendencias a la acción y procesos cognitivos (Scherer, 2005), con una duración determinada y una intensidad decreciente. La emoción es, pues, una disposición para la acción, no un acto en sí mismo, que tiene como base un componente corporal y una sensación consciente, el cual cuenta con una determinada dirección (Chronaki, Wigelsworth, Pell, & Kotz, 2018).

En esta misma línea, se desprenden un sinnúmero de trabajos en los que se afirma que la expresión de las emociones es muy similar en todos los seres humanos, a partir de la cual se han descrito «emociones básicas» presentes en diferentes contextos socioculturales. Las emociones han sido estudiadas desde distintos enfoques que pueden agruparse en modelos discretos o continuos. Los enfoques discretos asumen que existen emociones básicas bien caracterizadas, de las que se generan las demás (Ekman, 1972). Sin embargo, se ha encontrado que no existe una correspondencia unívoca entre emociones básicas y conductas o áreas cerebrales específicas (Scherer, 2005), por lo que no hay un acuerdo general sobre cuáles serían las emociones básicas.

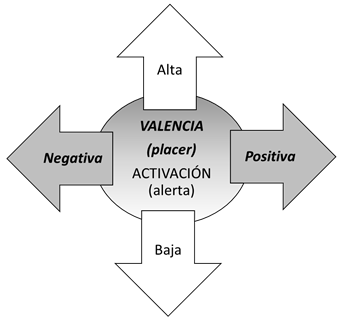

Por otro lado, están los enfoques continuos que describen las emociones dentro de un plano multidimensional, relacionándose entre sí con propiedades subjetivas (Russell, 1980; Russell & Mehrabian, 1977) y retomadas con mayor frecuencia en la literatura científica, como el modelo bioinformacional (Bradley & Lang, 1994). Este da cuenta de aquellas características que varían dependiendo de las reacciones fisiológicas en tres dimensiones: valencia (agradable o desagradable), activación (excitado o calmado) y dominancia (alta y baja). Los modelos discretos y continuos están relacionados, ya que las categorías emocionales discretas pueden ser descritas a través del modelo continuo.

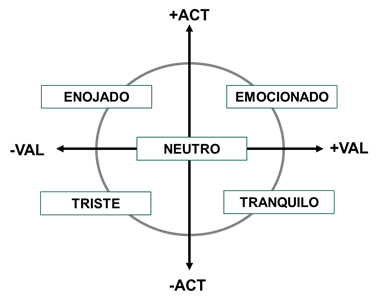

El modelo bioinformacional (Bradley & Lang, 1994) resulta útil para el estudio de las emociones más allá de las expresiones visibles -gestos, emociones, movimientos, etc.-, entre las que se encuentra el habla «evento acústico que refleja el funcionamiento del sistema nervioso central y por lo tanto acarrea información sobre el estado emocional de un individuo» (Espinosa & Reyes, 2010). De este modelo se rescatan las propiedades de activación y valencia, pues en ellas se presenta la mayor variabilidad y se ha observado mayor relación con las propiedades acústicas de la voz. La valencia, también llamada placer, describe qué tan negativa o positiva es una emoción específica, mientras que la activación, también llamada intensidad, describe la excitación o alerta interna de un individuo (ver Figura 1). Otra de las dimensiones es la de dominación, la cual describe el grado de control del individuo sobre la situación. No obstante, no se ha encontrado relación evidente de esta con patrones suprasegmentales de la emoción.

Figura 1

Propiedades de activación y valencia en el modelo bioinformacional.

Fuente: Bradley & Lang (1994).

Las propiedades de activación y valencia han sido utilizadas como marco de múltiples estudios en torno a las propiedades suprasegmentales de las emociones (Charpentier, Kovarski, Houy-Durand, Malvy, Saby, Bonnet-Brilhault, Latinus, & Gomot, M. ., 2018; Gilbers, Fuller, Gilbers, Broersma, Goudbeek, Free, & Başkent, , 2015; Luo, Fu, & Galvin, 2007), pues parten del supuesto de que estas van acompañadas de cambios fisiológicos que afectan la respiración, la fonación y la articulación y de patrones o configuraciones acústicas específicas según el tipo de emoción (Scherer, 2003).

Este modelo puede relacionarse directamente con la propuesta de (Gussenhoven, 2010) sobre la explicación del sistema paralingüístico a través de tres códigos biológicos: el de frecuencia, el de producción y el de esfuerzo. Cada uno de estos códigos tiene una relación fisiológica-funcional que está biológicamente determinada, pero se manifiesta dependiendo de las necesidades pragmáticas del hablante. Para este trabajo se rescata especialmente el código de esfuerzo, definido como el nivel o rango de energía alcanzado por la fuerza que se le imprime a la emisión. Esto produce movimientos más marcados con funciones de foco, pero también comparte las propiedades de activación y valencia descritas anteriormente, en el plano de la producción del habla y la interpretación afectiva.

3. Panorama de los estudios de prosodia emocional del español

Como se ha visto anteriormente, el estudio de las emociones como fenómeno paralingüístico presenta dificultades conceptuales, pues, dependiendo del modelo, es posicionado en diferentes niveles del proceso enunciativo; además, el concepto y la clasificación de las emociones también son caracterizados de múltiples formas. A pesar de ello, se han realizado estudios en diversas lenguas, incluida el español, especialmente el peninsular, como en los trabajos de Hidalgo Navarro (2020) y Rodero (2011) por mencionar algunos. A continuación, se realiza un breve resumen de algunas descripciones útiles para contextualizar el presente trabajo.

Las primeras descripciones del español de Navarro Tomás (1944) y otros estudios más recientes describen los enunciados declarativos típicamente con un final descendente, partiendo del núcleo hasta la juntura terminal L* L %, con variaciones dialectales en la sílaba nuclear (Prieto & Roseano, 2018). Este tipo de enunciado se toma como punto de referencia para la mayoría de las descripciones y comparaciones realizadas en torno a las emociones.

En otro estudio de español peninsular (Hidalgo Navarro, 2020) se describió la alegría, el enfado, el miedo, la sorpresa y la tristeza a partir de las variaciones de F0 en la curva tonal, además de considerarse la intensidad y la velocidad de la entonación; cabe apuntar que, en el caso de esta investigación, estos factores fueron comparados con el tono neutro. El autor realiza una descripción muy detallada en porcentaje de aparición de los diferentes tipos de curva y reporta similitudes en la velocidad entre alegría y tristeza, mientras que alegría y enfado tienen en común una F0 alta. Algunas de las conclusiones de este estudio es que las emociones de alegría y miedo solo se diferencian en la intensidad, y que pueden identificarse parámetros prosódicos coincidentes entre enfado y sorpresa.

En Venezuela, Martínez y Rojas (2011) realizaron el análisis de los correlatos acústicos de F0 e intensidad asociados a emociones actuadas -alegría, tristeza y rabia- en una misma oración, emitida por 5 hablantes. Encontraron que la tristeza se comporta de forma similar a los enunciados neutros, mientras que la rabia y la alegría tienen ascensos y descensos más marcados en la F0, pero se diferencian entre sí por la duración y velocidad, ya que en la rabia son menores.

Para el español de Colombia se encuentra un estudio (Velásquez, Garzón & Soto, 2018) en el que se describe la producción de 4 enunciados actuados en tono neutro, con tristeza, alegría y enojo. La curva entonativa de los enunciados analizados es representada mediante el sistema Sp_ToBI. Como resultado del análisis, se representa el tono neutro como plano y sostenido -H* H* H* M %-. La tristeza, por su parte, presenta una curva similar, pero con un descenso al final -H* H* H L* L%-. La alegría, con un patrón H*L+>H*H*L%, encuentra un ascenso progresivo desde la sílaba tónica hasta el punto máximo en el núcleo y termina en un tono descendente. El enojo se representa por L+¡H*L+>H*H+L*L% por sus movimientos ascendentes en el segmento prenuclear y nuclear, con un descenso en la juntura terminal. Al comparar la diferencia de F0, la única emoción que se diferencia de las demás es la alegría.

En cuanto a investigaciones relacionadas con el español de México, solo se encuentra la aproximación que hace Martín Butragueño (2016) a los actos de habla expresivos, a partir de una taxonomía continua de ánimo-desanimo. En este trabajo, describe que el pico inicial de los enunciados expresivos analizados generalmente es ascendente y que la valencia negativa de un enunciado se manifiesta en el pico prenuclear de forma descendente. Entretanto, el énfasis o fuerza ilocutiva alta se muestra en un acento nuclear ascendente, pero no integra las emociones como tal.

También existen estudios que modelan las emociones para integrarlas en sistemas de reconocimiento de texto a voz y viceversa. En un ejemplo de este tipo de estudios (Iriondo Guaus, Rodríguez, Lázaro, Montoya, Blanco, Bernadas, Oliver, Tena, & Longhi, 2000), se realiza un análisis suprasegmental de los patrones de voz de un corpus simulado de 7 emociones, el cual es validado a través de pruebas de percepción. Como resultado, se logra modificar la prosodia de un texto convertido a voz mediante técnicas de síntesis digital de audio. Aunque el objetivo de este y otros trabajos de este tipo tienen la finalidad de modelar una emoción artificialmente es importante rescatar los elementos que utilizan para lograrlo: el rango y variabilidad tonal, la velocidad de inflexiones tonales, la estabilidad en la intensidad y la duración de los silencios.

En otro trabajo (Montero, Gutiérrez-Arriola, Colás, Enríquez & Pardo, 1999) se validó y creó una base de datos de emociones en español simulado, incluyendo cuatro emociones: alegría, tristeza, enojo y sorpresa como parte del proyecto vaess (Voices Attitudes and Emotions in Synthetic Speech). Este estudio refleja la importancia de la calidad de voz en el reconocimiento de emociones por medio de la voz, y se encontró que la tristeza y la sorpresa se reconocen mejor por sus cualidades suprasegmentales, en comparación con el enojo y la alegría.

Otro estudio en español peninsular es el de modelización acústica (Rodríguez, Lázaro, Montoya, Blanco, Bernadas, Oliver, & Longhi,1999), en el que se creó un corpus de habla simulada con 8 actores y 7 emociones básicas: alegría, deseo, rabia, miedo, sorpresa, tristeza y asco, producidas con 3 niveles diferentes de intensidad cada una. A partir de este, se eligieron los 34 discursos mejor evaluados en una prueba de percepción. En esta investigación, se destaca que el análisis se realizó promediando parámetros acústicos concretos de entonación, intensidad, ritmo y timbre, no solo entre sujetos, sino también intrasujeto, con el fin de poder modelizar las emociones.

Al revisar todas estas aportaciones se detecta que en la mayoría se utilizan modelos discretos para la clasificación de las emociones y se utiliza el enunciado «neutro» como punto de referencia para hacer la comparación. También se observa que para su análisis se han utilizado los parámetros prosódicos de F0, intensidad y velocidad, así como la descripción de la curva tonal y los movimientos en el tonema. En ocasiones, parten de corpus espontáneos, pero en muchas otras de corpus actuados, ya sea con múltiples enunciados o con uno solo.

4. Metodología

4.1. Elaboración del corpus y elicitación de datos

Los datos que se utilizaron para este análisis fueron creados ad hoc para un instrumento de percepción de emociones. En este contexto fue importante evitar enunciados con una carga expresiva, controlar la duración, la estructura silábica y acentual. Teniendo en cuenta esto, se crearon 41 enunciados, todos ellos con vocabulario cotidiano, incluido en pruebas dirigidas a población infantil (Mansilla, 2005). Las oraciones fueron creadas manteniendo el mismo número de sílabas y ubicando los acentos léxicos en la misma posición para observar las prominencias tonales en una estructura similar del tipo: σσ*σσσ*σσσ* (σ = sílaba).

En cuanto a las emociones, se eligieron una para cada extremo del modelo bioinformacional, para tener el contraste de activación + ACT - ACT y valencia + VAL - VAL, además de la emoción neutra NEU como punto de referencia. Se consideran extremas, pues en los estudios previos de Russell (1980), Bradley y Lang (1994) las emociones seleccionadas para este estudio se han ubicado en este plano dimensional más lejanas del centro y en un punto medio entre los valores de activación y valencia de su cuadrante.

La muestra fue tomada de 3 hablantes nativas de español -en adelante, identificadas como M1, M2 y M3-, con residencia en Querétaro, México, ciudad cercana geográficamente a la Ciudad de México, pero que también colinda con otros estados considerados más cercanos al norte del país. Las tres informantes son adultas, con una edad promedio de 39 años (DE = 11.1), con estudios de licenciatura, profesionistas, familiarizadas con el manejo de la voz y la actuación, y en interacción constante con niños en el área laboral. En cuanto al tono de voz se refiere, la tesitura de las tres hablantes es similar y mantiene patrones suprasegmentales marcados de habla dirigida al niño.2

Para preparar a las hablantes se simularon situaciones en las que se dirigieran a un niño, poniendo el contexto con situaciones y apoyos visuales -fotografías con el gesto de cada emoción-. Se les pidió que evocaran la emoción mentalmente con una situación y posteriormente repitieran las 41 oraciones 3 veces con la entonación prototípica, basada en un estereotipo de nivel o expresión modelo (Scherer, 2003) para cada emoción: emocionado, enojado, neutro, tranquilo y triste. Todas las grabaciones se hicieron en una cabina sonoamortiguada y con una grabadora Tascam DR-100MKII, a una distancia de 30 cm. Las oraciones fueron revisadas acústica y visualmente, y se realizó una segunda toma de aquellas que tuvieran algún tipo de pausa, fraseo intermedio o función expresiva, con el fin de que todas ellas estuvieran en el mismo estatus informativo. En todos los casos no se forzó una realización prosódica determinada para la emoción, pero sí se les solicitó que dijeran la frase de corrido, sin énfasis en ningún elemento del enunciado.

4.2. Procesamiento de los datos

Una vez obtenidas las grabaciones, se utilizó el programa Praat 6.01.05 (Boersma & Weenik, 2019) para su análisis y segmentación. Utilizando el programa Audacity 2.3.2 (Mazzoni, 2019) todos los audios fueron normalizados a 65 dB SPL y se eliminó el ruido, manteniendo las variaciones de intensidad dentro de cada estímulo. Esta decisión metodológica se tomó sabiendo que la intensidad relativa es un elemento importante para el reconocimiento de emociones, pero no el más saliente, por lo que se discrimina menos entre emociones que el tono (Chatterjee, Kulkarni, Christensen, Deroche, & Limb, , 2015) en el que se enfoca este trabajo.

El proceso de etiquetado se hizo de forma intuitiva. Primero, se realizó la transcripción ortográfica del enunciado y la segmentación a nivel silábico y vocálico, identificando las vocales con acento léxico con (*). También se hizo una revisión independiente del pitch, restaurando los valores de la F0 donde se perdían o distorsionaban por presencia de ruido, microprosodia o voz laringizada. Por último, la curva tonal general es descrita mediante el sistema Sp_ToBI (Estebas-Vilaplana & Prieto, 2008).

5. Análisis de los datos

Se analizaron instrumentalmente las 1845 frases que conforman el corpus de estudio, extrayendo los promedios para cada vocal de: frecuencia fundamental (F0) en Hz, semitonos (st) e intensidad en decibeles (dB). A partir de estos valores, se llevaron a cabo varios análisis comparativos, tanto por emoción como por los niveles de activación y valencia, los cuales se describen a continuación. Para el análisis estadístico y la representación gráfica de resultados se utilizó el programa R-Studio v1.4.1717 (RStudio Team, 2021).

5.1. Parámetros generales

Al analizar la configuración global tonal de las tres hablantes (Tabla 1), se observa que tienen un promedio similar en todas las oraciones; solo se observa un mayor rango en st para M2. En cuanto a la realización específica de las emociones, se observa una reducción en promedio y rango de F0 -en el orden emocionado > enojado > tranquilo > triste > neutro para M2-, mientras que para M1 y M3 triste tiene promedios más altos, similares a los de emocionado y enojado.

Tabla 1

Medias de la F0 por hablante y por emoción

El rango tonal que hay entre el piso y el techo tonal por emoción permite ver la configuración global de las emociones (Tabla 2). Se observa que las emociones de activación alta como emocionado y enojado tienen un promedio de F0 mayor, pero se diferencian en el rango que es más elevado en emocionado. En cuanto a las emociones de activación baja, tranquilo y triste, se observa un rango tonal más bajo, pero no alcanzan al tono neutro. En la diferencia de rango, además, se puede observar que las emociones de valencia positiva tienen una diferencia mayor a las de valencia negativa. Entretanto, el tono neutro se encuentra por debajo de todos los valores asignados a las otras emociones. Al realizar el análisis estadístico, se encuentra que las emociones tienen una diferencia significativa en el promedio de F0 en Hz -F (4,160) = 3045.8; p < 0.01- marcadas con * en la Tabla 2.

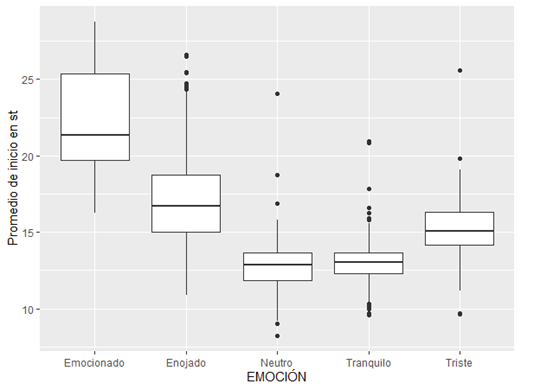

5.2. Inicio del enunciado

Las emociones pueden ser reconocidas con muy poca información acústica. El punto de inicio de una oración puede diferenciar su intención y en este caso la emoción (Castiajo & Pinheiro, 2019). Es por eso que la medida en st de la sílaba inicial permite reconocer si la diferencia es perceptible desde el primer momento. Para analizar la diferencia en el inicio de las oraciones, se realizaron varios ANOVA y se aplicó el ajuste post hoc de Bonferroni. El promedio de inicio de cada emoción fue el siguiente: 22.9 st para emocionado, 18.5 st para enojado, 13.04 st para neutro, 13.5 st para tranquilo y 15.6 st para triste, en comparación con la media total del tono neutro, que fue de 12.7 st. El promedio de inicio de cada emoción fue así: 22.9 st para emocionado, 18.5 st para enojado, 13.04 st para neutro, 13.5 st para tranquilo y 15.6 st para triste, en comparación con la media total del tono neutro, que fue de 12.7st. El análisis estadístico de estos datos muestra una asociación significativa por el punto de inicio -F (4,160) = 1858.8; p < 0.01-, mientras que en la prueba post hoc se encontró que todas son significativamente diferentes, excepto neutro y tranquilo que, como puede verse en la Figura 3, comparten la misma tendencia de inicio, por lo que solo podrían diferenciarse aquellas que están a los extremos.

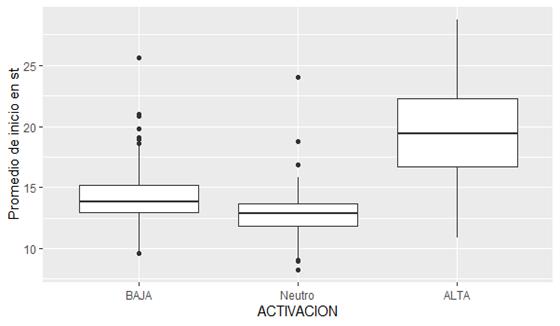

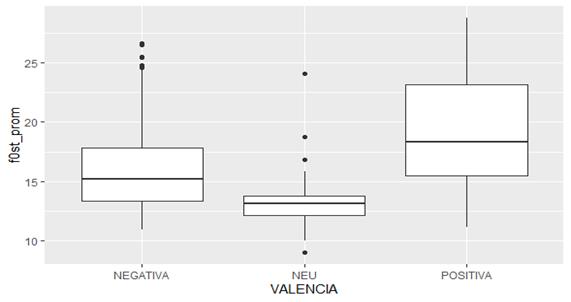

En este caso se aplicó la clasificación propuesta dentro del modelo bioinformacional de las emociones seleccionadas a partir de su nivel de activación y valencia. La diferencia entre los dos niveles de activación y valencia puede observarse en las Figura 4 y 5. El análisis estadístico para el factor de activación en sus tres niveles -alta, baja y neutra- muestra un efecto significativo en el promedio de inicio -F (2,80) = 3287.58; p < 0.01-. También se realizó el análisis estadístico para el factor de valencia, en el que se encuentra una diferencia significativa entre los tres niveles -positiva, neutra y negativa- -F (2,80) = 1923.45; p < 0.01-. Esto implica que los tres niveles son significativamente diferentes en la altura tonal de su sílaba inicial y, por ende, la prueba post hoc confirmó la diferencia significativa entre los niveles p < 0.01, tanto para los niveles de activación como de valencia.

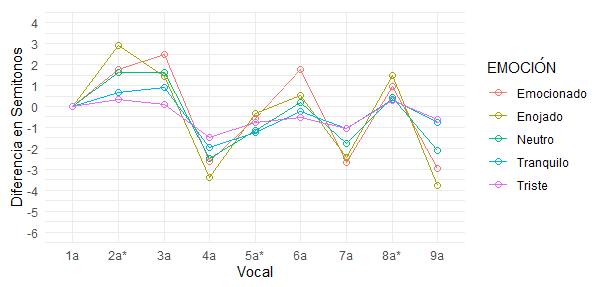

5.3. Curva tonal

Para la descripción de la curva tonal se extrajeron los valores absolutos de todas las vocales para observar el movimiento general y establecer así los movimientos más amplios. Después, se hizo un análisis relativo de las variaciones de st entre segmentos y se identificaron aquellos en los que las emociones presentaban diferencias significativas entre sí. A partir de la medición en semitonos, se calculó la diferencia entre vocales, para determinar aquellos movimientos mayores a 1.5 st, tomando en cuenta el umbral de percepción descrito anteriormente. Con estos mismos valores se obtuvo una curva que representa el tipo de movimiento, ya sea ascenso o descenso que hay entre las sílabas (Figura 6). Esta representación gráfica es de desarrollo propio y va de la mano de la propuesta metodológica del análisis en contexto de la diferencia entre sílabas acentuadas. En un primer momento, puede observarse que la diferencia se hace más significativa cuando el código de esfuerzo es mayor, lo que corresponde a una activación alta como en emocionado y enojado, aunque la configuración general no cambia y se asemeja a la configuración esperada para enunciados declarativos.

En los enunciados neutros se observa un inicio acorde a la descripción de un enunciado aseverativo del español (Navarro Tomás, 1944; Quilis, 1997), caracterizado por un comienzo en tono medio que se eleva progresivamente hasta la sílaba tónica y encuentra su pico tonal alineado a la derecha en la sílaba postónica L+>H* (Estebas Vilaplana & Prieto, 2008), así como con un patrón circunflejo en el tonema, como el descrito para los enunciados aseverativos de foco amplio del español de la Ciudad de México (Martín Butragueño, 2017).

El segmento prenuclear se caracteriza por ser bitonal en emociones de activación alta -emocionado yenojado- con un ascenso mayor a 3 st, mientras que las emociones de activación baja -triste y tranquilo- son monotonales. En este segmento es interesante observar que las emociones de valencia positiva -emocionado y tranquilo- presentan un pico desplazado, mientras que las de valencia negativa sí se definen en la sílaba tónica.

En los enunciados con activación alta, la diferencia en estos movimientos tonales es mayor, observando ascensos mayores a 1.5 st en todas las sílabas y, por lo tanto, más evidente su contraste con los de activación baja. En los enunciados de tristeza, se observa también el inicio en un tono alto que, a diferencia de lo reportado en otros trabajos (Velásquez, Garzón, & Soto ., 2018) no desciende en el tonema, sino que se mantiene M %. En la Tabla 3 puede observarse un resumen de la configuración general del tono por sílaba en cada una de las emociones.

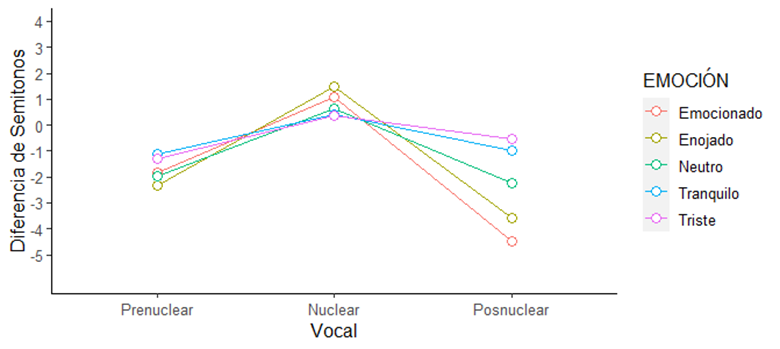

5.4. Configuración nuclear por emoción

La configuración nuclear es fundamental, pues es en este segmento en donde se consolida el sentido de unidad y significado del enunciado y en donde se realizan variaciones que pueden proyectar la intención del hablante. Para este análisis se observa solamente la diferencia en st del segmento prenuclear, nuclear y el posnuclear (Figura 7). En esta gráfica se puede observar el tonema con el movimiento circunflejo descrito anteriormente del habla de la zona central de México (Martín Butragueño, 2017) para el tono neutro y con un descenso más pronunciado en el caso de las emociones de activación alta !L %, mientras que las de activación baja se mantienen M %.

6. Conclusiones

Con base en el marco metodológico del que parte este estudio, se evidencia la razón de la carencia de estudios suficientes en torno a este elemento paralingüístico. La propuesta de análisis en este trabajo es valiosa en sí misma por tratarse de un primer acercamiento a la descripción de la prosodia de las emociones en el español mexicano. Además, la propuesta específica de este trabajo, que consiste en la agrupación de las emociones en torno a las dimensiones de activación y valencia, provee una posibilidad de caracterización que no se ha utilizado en el español. También resulta valioso el uso de la medida en st, pues al comparar con estudios previos (Rodríguez, Lázaro Montoya, Blanco, Bernadas, Oliver, & Longhi, 1999), en los que las variaciones tonales se reportan con porcentajes, es difícil comparar las variaciones tonales entre emociones, pues se necesita convertir a una medida relativa que las haga equiparables, como la propuesta en st. Al traducir las medidas absolutas, tenemos información que, inclusive, permite agrupar las emociones en rasgos como la activación y la valencia para analizar su comportamiento tonal.

A partir de esta propuesta de análisis se encuentran más regularidades asociadas a este código de esfuerzo, y pueden ser una guía para la caracterización de las emociones en contornos diferenciados y la agrupación por las propiedades mismas de las emociones. Por el momento, los resultados observados en la configuración del inicio y nuclear brindan la posibilidad de caracterizar las emociones por su nivel de activación. Aunque la F0 no permite identificar la valencia, sí se observó el pico desplazado en la sílaba inicial de los enunciados con valencia positiva, mientras que en las de valencia negativa el pico está en el núcleo de la juntura inicial. Los datos que proveen este corpus aún presentan la posibilidad de análisis de factores como la duración y la intensidad relativa, que aunque juegan un papel importante en la producción de las emociones, sobrepasan el alcance de este estudio.

Los valores obtenidos en las curvas por emoción presentan valores similares a los que se comparten en el trabajo de Montero, Gutiérrez-Arriola, Colás, Enríquez y Pardo (1999) en cuanto al tono de la sílaba inicial de las emociones. También se encuentra similitud con el trabajo de Hidalgo Navarro (2020), pues caracteriza la alegría y el enfado con una F0 alta, relacionada con las excursiones tonales de la alegría y el enojo en el corpus de este trabajo. Mientras que los enunciados tristes y neutros que Martínez y Rojas (2011) encuentran similares, aquí se encontró que son diferentes en cuanto a la sílaba inicial y tampoco comparten la configuración del tonema. Al contrastar con el español de Colombia (Velásquez, Garzón & Soto , 2018) se observan configuraciones tonales distintas, pues la variante del español en México presenta el patrón circunflejo, excursiones tonales más pronunciadas y acentos bitonales recurrentes.

Aunque este trabajo tiene limitaciones metodológicas en cuanto al número de hablantes y espontaneidad de los estímulos, la sistematicidad con la que se crearon los enunciados y la manera como se realizó el análisis dan cuenta real de variaciones que pueden ser utilizadas como referencia para estudios posteriores. Sería muy importante integrar a este análisis la variabilidad entre hablantes hombre-mujer y las mismas oraciones, con el propósito de que puedan servir para comparar con otras variaciones dialectales dentro del mismo español mexicano. También sería conveniente controlar la coda de la sílaba final, pues en el análisis se observaron fenómenos de ensordecimiento o elisión de fonemas, aunado al debilitamiento natural del habla queretana.

Además, será importante probar estas distinciones frente a la capacidad de reconocerlas en una tarea perceptual, para integrar el fenómeno de la emoción desde el punto de vista de la interacción, en donde la realización de las emociones en la voz realmente tiene su fundamento. La revisión de la descripción propuesta en este trabajo, tomando en cuenta los enunciados con las formas acústicas emocionales más perceptibles, también será una forma de afinar con más detalle los rasgos acústicos que permiten reconocer las emociones y agruparlas por sus niveles de activación y valencia de una forma aún más clara.